Die Foren-SW läuft ohne erkennbare Probleme. Sollte doch etwas nicht funktionieren, bitte gerne hier jederzeit melden und wir kümmern uns zeitnah darum. Danke!

Citrix Xen-Server, VMWare EsXi 4, Hyper v?

@ gea

sag doch noch was zu dem indestanforderungen an die SAN VM.

@ all

Gibt es sowas wie einen _einfachen_ Benchmark für VMWare ESXi 4.1? Um festzustellen ob der Server rund läuft und wo evtl. Flaschenhälse sind? Vielleicht sowas wie eine vorkonfigurierte Benchmark Appliance zum runterladen?

Ich hab diesen "VMMark" direkt von VMWare gefunden aber der scheint doch eher was für größere Maschinen zu sein oder läuft er auch auf einem Einzelsystem mit 6 Kern CPU?

sag doch noch was zu dem indestanforderungen an die SAN VM.

@ all

Gibt es sowas wie einen _einfachen_ Benchmark für VMWare ESXi 4.1? Um festzustellen ob der Server rund läuft und wo evtl. Flaschenhälse sind? Vielleicht sowas wie eine vorkonfigurierte Benchmark Appliance zum runterladen?

Ich hab diesen "VMMark" direkt von VMWare gefunden aber der scheint doch eher was für größere Maschinen zu sein oder läuft er auch auf einem Einzelsystem mit 6 Kern CPU?

e-e-e hat geschrieben:Hallo,

versuch's mal hiermit http://www.napp-it.org/napp-it/all-in-one/index.html.

Wenn Du dem zpool z.B. 3 - 4 SATA-HDD-mirrors + 2 SSDs als mirror für slog und cache gibst, wird die Kiste recht flott.

Habe für mehere Kunden schon Systeme mit openSUSE + WS und als local storage über zfs-fuse obige ZFS-Konstellation eingerichtet, und bis jetzt keine Klagen über schlechte Performance, trotz der ungünstigen zfs-fuse-Lösung. Dort laufen dann 5-7 VMs.

Da alle Komponenten frei verfügbar sind, probier's doch einfach mal aus.

Und ich biete auch Expertiese mit Nativem ZFS unter Linux an. Gerne kannst du auch eine VM mit Debian GNU Linux und ZFS downloaden.

Auf dem Desktop benutze ich RHEL 6 mit ZFS für Daten

Danke für das Angebot. Ich bin schon recht weit mit meiner all-in-one Version mit ESXi 4.01 und NexentaCore 3.0.1. Das Testsystem läuft schon.

Nun warte ich noch auf meine bestellten 3 x Hitachi Deskstar 5K3000 2000GB HDDs (mehr war im Moment finanziell nicht drin) um die als ZFS Z1 laufen zu lassen.

Was mich immer noch interessieren würde sind Benchmarks für den ESXi. Die Plattenperformance kann man ja bequem mit dem eingebauten Benchmark in Napp-It messen.

Per Windows SMB kann ich mein FZS Filesystem ja nun sehen. Nun scheitere ich daran die NFS Freigabe (ist im Napp-it naütrlich auf ON) im ESXi Server einzugeben.

Er findet das immer nicht. Als Server gebe ich im die IP Adresse der VM also 192.168.0.225 in meinem Fall. Ich denke das ist ok.

Aber was kommt im Feld "Ordner"? Ich habe ausproiert:

\testfilesystem

\testfilesystem\

\testpool\testfilesystem

wird nix... Fehlermeldung im ESXi: " ... Unable to complete sysinfo operation .... "

Nun warte ich noch auf meine bestellten 3 x Hitachi Deskstar 5K3000 2000GB HDDs (mehr war im Moment finanziell nicht drin) um die als ZFS Z1 laufen zu lassen.

Was mich immer noch interessieren würde sind Benchmarks für den ESXi. Die Plattenperformance kann man ja bequem mit dem eingebauten Benchmark in Napp-It messen.

Per Windows SMB kann ich mein FZS Filesystem ja nun sehen. Nun scheitere ich daran die NFS Freigabe (ist im Napp-it naütrlich auf ON) im ESXi Server einzugeben.

Er findet das immer nicht. Als Server gebe ich im die IP Adresse der VM also 192.168.0.225 in meinem Fall. Ich denke das ist ok.

Aber was kommt im Feld "Ordner"? Ich habe ausproiert:

\testfilesystem

\testfilesystem\

\testpool\testfilesystem

wird nix... Fehlermeldung im ESXi: " ... Unable to complete sysinfo operation .... "

Wirrkopf hat geschrieben:Kann man dann also die Storage VM mit dem ZFS mti einer vCPU und 2 GB RAM (oder weniger?) laufen lassen ohne das es bremst?

OpenIndiana/ Solaris/ Nexenta brauchen mindestens 1 GB RAM. und sollten

als 64 Bit installiert werden. Das ist jedoch nur das OS.

Alles was darüber als freier RAM zur Verfügung steht wird zu Cachen benutzt,

bringt also Performance. CPU ist nicht ganz so kritisch, es sollten 1-2 vCPU verwendet werden

(keinesfalls mehr). Bei wenig Performance und RAM auf jeden Fall auf Dedup verzichten,

Komprimierung geht meist auch bei relativ wenig CPU Leistung.

Wenn es richtig schnell sein soll, dann ordentlich RAM geben.

Meine All-In-One haben > 24 GB RAM total und > 8 GB RAM für ZFS

NFS Pfade sind immer absolut, also /pool/ZFS folder

bei Problemen permissions des ZFS folder auf 777 setzen und NFS restart probieren

-

irix

- King of the Hill

- Beiträge: 12944

- Registriert: 02.08.2008, 15:06

- Wohnort: Hannover/Wuerzburg

- Kontaktdaten:

Wirrkopf hat geschrieben:....

\testfilesystem

\testfilesystem\

\testpool\testfilesystem

wird nix... Fehlermeldung im ESXi: " ... Unable to complete sysinfo operation .... "

NFS ist UNIX Land und richtige Maenner nehmen dann den Slash und nicht den Backslash. Ausser du bist Chuck Norris, weil dann gehts auch mit dem Dash.

Gruss

Joerg

Den zpool mit nur 3 HDDs als raidz1 ist keine grandiose Idee, dann hol' dir wenigstens noch 2 SSDs ca. 30GB und mach' je 2 Partitionen drauf für log (1x Mirror - 2GB) und cache (die jeweils andere Partition - 2x28GB). Wenn du dann irgendwann noch 1 bzw. 3 weitere HDDs (zusammen dann als 2 oder 3x Mirror) einbaust, bekomst du richtig gute Performance.

e-e-e hat geschrieben:Den zpool mit nur 3 HDDs als raidz1 ist keine grandiose Idee, dann hol' dir wenigstens noch 2 SSDs ca. 30GB und mach' je 2 Partitionen drauf für log (1x Mirror - 2GB) und cache (die jeweils andere Partition - 2x28GB). Wenn du dann irgendwann noch 1 bzw. 3 weitere HDDs (zusammen dann als 2 oder 3x Mirror) einbaust, bekomst du richtig gute Performance.

Hi e-e-e-, Deinen Tipp verstehe ich nicht. Die 3 x 2 GB HDDs haben mich 3 x 50 € gekostet (meinPaket Aktion). Auf eine 3,4,5 HDD habe ich verzichtet weil die 150 € für die 3 HDDs im Moment das Maximum sind was ich ausgeben kann. Board, CPU und RAM kommen ja noch dazu da ich im Moment nur ein geliehenes Testsystem nutze. Da bin ich zusammen mit den drei HDDs dann doch schon bei 600 € und eigentlich 100 € über meinen angedachten Limit.

Ich kann mir nicht vorstellen das 2 x SSDs jetzt deutlich preisgünstiger sind als wenn ich mir gleich weitere HDDs gekauft hätte oder gibt es die "kleinen" SSDs irgendwo sehr günstig? Update: Also laut Geizhals kostet mich eine 32 GB SSD soviel wie eine weitere 2 GB HDD.... Finde ich jetzt eher teuer... Gibt es da Messungen wieviel so eine/zwei SSDs so ein Raid Z1 beschleunigen?

Geplant habe ich den Kauf von SSDs als Beschleuniger durchaus, aber erst wenn ich Geld über haben sollte....

Aber mal abgesehen vom Optimum: Kann man keine Prognose geben wie schnell ein Z1 mit drei HDDs ungefähr sein wird? Eine einzelne HDD liefert ungefähr 140 MB/s beim lesen am Stück.

Hallo,

raidzx ist immer dort gut, wo es auf Speicherplatzoptimierung ankommt (z.B. BackupServer). Wenn du Performance brauchst, ist ein zpool aus mehreren Spiegeln günstiger (z.B. 6x HDD in 3x Einfachspiegel aufgeteilt). Um jetzt noch den zpool/ZFS zu beschleunigen, sollte man dann noch SSDs für log und cache hinzufügen (log immer auch als Spiegel). SSDs sind zwar verhältnismäßig teuer, aber der Performancegewinn massiv. Bei meinem Post hatte ich diese beiden Aspekte beschrieben und ich glaube du hast sie beide zusammengeschmissen.

Bei dir könnte dann z.B. die Ausgabe auf ein

so aussehen.

raidzx ist immer dort gut, wo es auf Speicherplatzoptimierung ankommt (z.B. BackupServer). Wenn du Performance brauchst, ist ein zpool aus mehreren Spiegeln günstiger (z.B. 6x HDD in 3x Einfachspiegel aufgeteilt). Um jetzt noch den zpool/ZFS zu beschleunigen, sollte man dann noch SSDs für log und cache hinzufügen (log immer auch als Spiegel). SSDs sind zwar verhältnismäßig teuer, aber der Performancegewinn massiv. Bei meinem Post hatte ich diese beiden Aspekte beschrieben und ich glaube du hast sie beide zusammengeschmissen.

Bei dir könnte dann z.B. die Ausgabe auf ein

Code: Alles auswählen

zpool status tank0NAME STATE READ WRITE CKSUM

tank0 ONLINE 0 0 0

mirror-0 ONLINE 0 0 0

disk/by-id/ata-SAMSUNG_SP1614C_S01XJ10X889101 ONLINE 0 0 0

disk/by-id/ata-SAMSUNG_HD160JJ_S08HJ1TLA36602 ONLINE 0 0 0

mirror-1 ONLINE 0 0 0

disk/by-id/ata-SAMSUNG_SP2504C_S09QJ1HP109456 ONLINE 0 0 0

disk/by-id/ata-SAMSUNG_SP2504C_S09QJ1HP109455 ONLINE 0 0 0

mirror-2 ONLINE 0 0 0

disk/by-id/ata-SAMSUNG_HD160JJ_S08HJ1TLA36595 ONLINE 0 0 0

disk/by-id/ata-SAMSUNG_SP1614C_S01XJ10Y252418 ONLINE 0 0 0

logs

mirror-3 ONLINE 0 0 0

c2t0d0p0 ONLINE 0 0 0

c3t0d0p0 ONLINE 0 0 0

cache

c2t0d0p1 ONLINE 0 0 0

c3t0d0p1 ONLINE 0 0 0

so aussehen.

Ich hab jetzt das den NFS Share als ESXI Dateispeicher eingebunden und eine Win7 VM testweise darauf installiert. Ein Benchmark mit ATTO in der VM wirft nun max. 25 MB schreibend und 195 MB lesend aus. Etwas besser als der in Napp-It eingebaute Bechmark. Mit der Leserate bin ich ja auch sehr zufrieden aber die Schreibrate ist ungenügend...

Dann habe ich die Compression im Napp-it für das ZFS Dateisystem mal aktiviert und die Schreibrate hat sich immerhin auf knapp über 42 MB/s gesteigert wobei die Leserate auf 176 MB/s gefallen ist.

Meine Frage ob die Schreibrate (ohne Kompression) so "normal" ist steht weiterhin im Raum. Wenn Die Platte nativ ca. 70 MB/s schreibend schafft wieso sinkt diese Rate dann in einem ZFS Mirror aus zwei Platten so ab? Ich hätte vermutet das die ungefähr gleich der normalen Einzelschreibrate sein müßte. Was bremst denn da beims schreiben? Bei einem Mirror wird doch nix berechnet oder doch?

Und wenn ich den ATTO Bechmark richtig verstehe schrebt er für den test ein 8 MB größes File. Die NexentaCore VM hat aber 2 GB RAM: Davon soll ja alles was das OS nicht selber benötigt als Cache funktionieren. Sollten da die "winzigen" 8 MB nicht locker reinpassen so das der Bechnmark eigentlich "rasen" sollte? Oder wie funktioniert das mit dem Cache in ZFS/Nexenta?

Dann habe ich die Compression im Napp-it für das ZFS Dateisystem mal aktiviert und die Schreibrate hat sich immerhin auf knapp über 42 MB/s gesteigert wobei die Leserate auf 176 MB/s gefallen ist.

Meine Frage ob die Schreibrate (ohne Kompression) so "normal" ist steht weiterhin im Raum. Wenn Die Platte nativ ca. 70 MB/s schreibend schafft wieso sinkt diese Rate dann in einem ZFS Mirror aus zwei Platten so ab? Ich hätte vermutet das die ungefähr gleich der normalen Einzelschreibrate sein müßte. Was bremst denn da beims schreiben? Bei einem Mirror wird doch nix berechnet oder doch?

Und wenn ich den ATTO Bechmark richtig verstehe schrebt er für den test ein 8 MB größes File. Die NexentaCore VM hat aber 2 GB RAM: Davon soll ja alles was das OS nicht selber benötigt als Cache funktionieren. Sollten da die "winzigen" 8 MB nicht locker reinpassen so das der Bechnmark eigentlich "rasen" sollte? Oder wie funktioniert das mit dem Cache in ZFS/Nexenta?

Solange du im zpool kein separate log (slog) auf SSD einsetzt, werden die logs mit auf die HDDs geschrieben und ein commit der Schreiboperation auf den NFS-Share lässt auf sich warten.

Hier noch ein wenig Lesestoff: http://www.solarisinternals.com/wiki/index.php/ZFS_Best_Practices_Guide

Zu den 8MB-Dateien: Das ist ja nicht immer die selbe, ist der Cache voll, muss auf die HDDs geschrieben werden. Er schreibt ja nicht nur EINE 8MB-Datei.

Welche Checksum ist eingestellt?

Hier noch ein wenig Lesestoff: http://www.solarisinternals.com/wiki/index.php/ZFS_Best_Practices_Guide

Zu den 8MB-Dateien: Das ist ja nicht immer die selbe, ist der Cache voll, muss auf die HDDs geschrieben werden. Er schreibt ja nicht nur EINE 8MB-Datei.

Welche Checksum ist eingestellt?

e-e-e hat geschrieben:Welche Checksum ist eingestellt?

Wo stelle ich die ein? im Napp-it oder wo ...?

Ich habe keine Checksummen verändert also wird es wohl der installationsstandard sein...

Und wenn SSDs für das/die Logs so viel bringen: Sag mal ne Hausnummer was das an Beschleunigung bringen würde. 2x, 3x ?

Auf dem Storage als root ein und dann bekommst du alle Infos zu zpool und ZFS.

Edit: Der Beschleunigungsfaktor hängt ganz von der Nutzung ab, aber 2x wird es wohl nicht werden, da helfen dann nur noch weitere HDDs, wie schon gesagt z.B. 3x2 Stück, ich recycle da oft viele kleine alte HDDs der Kunden, auch unterschiedlich große. Meine Kunden sind oft sehr kleine Firmen mit nur einer Bürokraft + div. Außendienstler, da kommt's auf jeden Euro an und mit einem ZFS muss es nicht unbedingt Serverhardware sein.

Code: Alles auswählen

zpool get all <Poolname>Code: Alles auswählen

zfs get all <ZFS/Poolname>Edit: Der Beschleunigungsfaktor hängt ganz von der Nutzung ab, aber 2x wird es wohl nicht werden, da helfen dann nur noch weitere HDDs, wie schon gesagt z.B. 3x2 Stück, ich recycle da oft viele kleine alte HDDs der Kunden, auch unterschiedlich große. Meine Kunden sind oft sehr kleine Firmen mit nur einer Bürokraft + div. Außendienstler, da kommt's auf jeden Euro an und mit einem ZFS muss es nicht unbedingt Serverhardware sein.

also bei checksum steht nur "on"

Hier malalle Daten die ausgeworfen wurden:

http://www.bilder-hochladen.eu/show.php ... 5oCx7W.png

Hier malalle Daten die ausgeworfen wurden:

http://www.bilder-hochladen.eu/show.php ... 5oCx7W.png

e-e-e hat geschrieben:Hallo,

für testpool hast du ja die Kompression ausgeschaltet, schalt mal wieder ein und dann könntest du noch atime (Aktualisierungzeit) ausschalten, um weniger IOs zu erzeugen.

Ich habe jetzt die Comnpression für "Testpool" aktivieert. Ich hatte ja bereits die Compression für "Testfilesystem" (unterhalb von Pool "Testpool) aktiviert. Reichte das nicht? Bzw. wie sind die unterschiedlichen Auswirkungen wenn man für POOL / Filesystem das gleich/unterschiedlich aktiviert?

An Kombinationen wären ja vier Möglichkeiten denkbar: an/an, an/aus, aus/an, aus/aus....

Wo stelle ich "atime" aus? In der Napp-It GUI finde ich das nicht. Wieviel wird das denn bringen und was sind evtl. Nachteile?

Ich hab jetzt mal jede Menge Benchmarks laufen lassen um ein wenig Fakten liefern zu können und hoffe das dieses zu erhellenden Antworten beiträgt

Im Bonnie Benchmark auf den ganzen Pool erreiche ich mit 67 MB/s auch eine normale Schreibrate.

Hier das Ergebnis ohne Compression

Auch im DD bench aus dem Napp-It sieht es mit 73 MB/s für die lahmen 500 GB Platten ok aus:

Hier der dd Bench ohne Compression

Wo es ganz und gar nicht ok aussieht sind die Schreibzugriffe über die SMB Freigabe ohne Compression. Es werden nicht mal 15 MB/s erreicht!

Hier der ATTO Benchmark Wert ohne Compression.

Wenn ich die Compression aktiviere (sowohl für den Pool als auch für das Filesystem) wird es stark beschleunigt. Werte von über 60 MB/s sind ok wobei mir da nicht klar ist ob das evtl. nur so gut aussieht weil das testfile aus dem Benchmark gut zu komprimieren ist und das mit Echtdaten genauso schlecht aussieht wie mit deaktivierte Compression?

Hier der ATTO Bechmark Wert mit Compression.

Dabei ist es egal ob der Client eine VM auf dem selben ESXi Server ist oder die Daten wirklich über den echten GB Switch gehen. Das Ergebnis ist ziemlich identisch.

Wenn ich dann den Speed der virtuellen "Systemplatte" einer VM die über NFS auf dem NexentaCore liegt dann ist es schon deutlich besser als über die SMB Freigabe aber mit ca 50 MB/s immmer noch weniger als die erwarteten ~ 70 MB/S. Die VM sollte ja über den internen Switch gehen also sollte das kein limitierender Faktor sein wobei die realen ca. 70 MB/s (die nicht erreicht werden) auch über GB noch machbar sein sollten.

Gestern waren die Werte merkwürdigerweise noch deutlich geringer. Heute haben sie sich auf max. 50 MB/s gesteigert. :confused:

Hier mal die ATTO Benchmark von einer VM die auf dem NFS Dateispeicer liegt ohne Compression

und hier mit Compression

Wobei hier die Compression eher bremst als beschleunigt.

Im Bonnie Benchmark auf den ganzen Pool erreiche ich mit 67 MB/s auch eine normale Schreibrate.

Hier das Ergebnis ohne Compression

Auch im DD bench aus dem Napp-It sieht es mit 73 MB/s für die lahmen 500 GB Platten ok aus:

Hier der dd Bench ohne Compression

Wo es ganz und gar nicht ok aussieht sind die Schreibzugriffe über die SMB Freigabe ohne Compression. Es werden nicht mal 15 MB/s erreicht!

Hier der ATTO Benchmark Wert ohne Compression.

Wenn ich die Compression aktiviere (sowohl für den Pool als auch für das Filesystem) wird es stark beschleunigt. Werte von über 60 MB/s sind ok wobei mir da nicht klar ist ob das evtl. nur so gut aussieht weil das testfile aus dem Benchmark gut zu komprimieren ist und das mit Echtdaten genauso schlecht aussieht wie mit deaktivierte Compression?

Hier der ATTO Bechmark Wert mit Compression.

Dabei ist es egal ob der Client eine VM auf dem selben ESXi Server ist oder die Daten wirklich über den echten GB Switch gehen. Das Ergebnis ist ziemlich identisch.

Wenn ich dann den Speed der virtuellen "Systemplatte" einer VM die über NFS auf dem NexentaCore liegt dann ist es schon deutlich besser als über die SMB Freigabe aber mit ca 50 MB/s immmer noch weniger als die erwarteten ~ 70 MB/S. Die VM sollte ja über den internen Switch gehen also sollte das kein limitierender Faktor sein wobei die realen ca. 70 MB/s (die nicht erreicht werden) auch über GB noch machbar sein sollten.

Gestern waren die Werte merkwürdigerweise noch deutlich geringer. Heute haben sie sich auf max. 50 MB/s gesteigert. :confused:

Hier mal die ATTO Benchmark von einer VM die auf dem NFS Dateispeicer liegt ohne Compression

und hier mit Compression

Wobei hier die Compression eher bremst als beschleunigt.

Hallo,

auf dem Nexenta (Console) kannst du als root direkt eingeben und damit atime ausschalten. Dadurch wird die Speicherung der letzten Änderungszeit für Dateien ausgeschaltet.

Die Angabe checksum=on bedeutet, dass die Standardeinstellung mit fletcher-2 aktiviert ist, das reicht zur normalen Fehlererkennung vollkommen.

Was die Kompression bringt, hängt natürlich von den zu komprimierenden Daten ab, ich habe damit gute Erfahrungen gemacht.

Mich hat irritiert, dass du heute von einer lahmen 500GB-Platte berichtest, ich dachte du verwendest 3x2TB im raidz, dabei wird ja immer eine XOR-Operation durchgeführt und auf die 3. Platte geschrieben. Weiterhin ist die gesamte Schreiboperation erst nach allen Schreibzugriffen auf die 3 Platten beendet.

Bei den Werten vergiss bitte nie, dass die Übertragungsprotokolle nicht 100% Nutzdaten liefern. Bei Samba bin ich nicht sicher, ob man da was schrauben kann, beim NFS solltest du nach dem best-practice-guide vorgehen. Die MTU solltest du auf jeden Fall hochzuschrauben (92679).

auf dem Nexenta (Console) kannst du als root direkt

Code: Alles auswählen

zfs set atime=offDie Angabe checksum=on bedeutet, dass die Standardeinstellung mit fletcher-2 aktiviert ist, das reicht zur normalen Fehlererkennung vollkommen.

Was die Kompression bringt, hängt natürlich von den zu komprimierenden Daten ab, ich habe damit gute Erfahrungen gemacht.

Mich hat irritiert, dass du heute von einer lahmen 500GB-Platte berichtest, ich dachte du verwendest 3x2TB im raidz, dabei wird ja immer eine XOR-Operation durchgeführt und auf die 3. Platte geschrieben. Weiterhin ist die gesamte Schreiboperation erst nach allen Schreibzugriffen auf die 3 Platten beendet.

Bei den Werten vergiss bitte nie, dass die Übertragungsprotokolle nicht 100% Nutzdaten liefern. Bei Samba bin ich nicht sicher, ob man da was schrauben kann, beim NFS solltest du nach dem best-practice-guide vorgehen. Die MTU solltest du auf jeden Fall hochzuschrauben (92679).

Ich habe zur Zeit ein geliehenes Testsystem. In dem sind die 2 x 500 GB als Mirror.

Ausserdem baue ich gerade das eigentliche System zusammen (Sobald die bestellen Teile da sind) das sich etwas vom Testsystem unterscheiden wird. Die CPU wird z. B. 6 x 3,3 Ghz haben statt der 6 x 2,8 und statt der 2 x 500 GB wird das eigentliche System 3 x 2000 GB (als Z1) haben. Sobald wie möglich werde ich noch 3 HDDs dazukaufen und das Z1 auf 6 x 2000 GB ausbauen. Auch das RAM ist im Testsystem nur 8 GB und wird im richtigen System dann 16 GB sein.

Die 3 x 2000 GB HDDs sind heute gekommen und ich baue sie gerade in das Testsystem ein. Mal sehen wie sich die Werte verändern.

Ausserdem baue ich gerade das eigentliche System zusammen (Sobald die bestellen Teile da sind) das sich etwas vom Testsystem unterscheiden wird. Die CPU wird z. B. 6 x 3,3 Ghz haben statt der 6 x 2,8 und statt der 2 x 500 GB wird das eigentliche System 3 x 2000 GB (als Z1) haben. Sobald wie möglich werde ich noch 3 HDDs dazukaufen und das Z1 auf 6 x 2000 GB ausbauen. Auch das RAM ist im Testsystem nur 8 GB und wird im richtigen System dann 16 GB sein.

Die 3 x 2000 GB HDDs sind heute gekommen und ich baue sie gerade in das Testsystem ein. Mal sehen wie sich die Werte verändern.

Die drei neuen 2000 GB HDDs sind drin. In Nexenta schnell einen Pool mit allen drei als Mirror erstellt und ein Dateisystem. Als NFS und SMB freigegeben. 2 GB vRam und 2 vCPUs

91 MB/s beim schreiben und 246 MB/s beim lesen sind ok. Bei einer zweiten Messung habe ich das vRam auf 4 GB erhöht. Die Schreibrate steigt dann auf 127 MB/s, sie Leserate sinkt aber auf 207 MB/s...?

Die Werte vom Bonni Benchmark sehen mit 107 MB/s schreibend und 246 MB Lesend auch ok aus.

Erste Messung von einem echten CLient über den GB Switch ohne Kompression.

Read max 25 MB/s und Lesen max. 88 MB/s.... Also im Vergleich zum 2 x 500 GB Mirror auch nicht viel Besser. Dafür das jede einzelne der neuen Platten140 MB/s schafft frage ich mich wo da die Performance verbrannt wird???

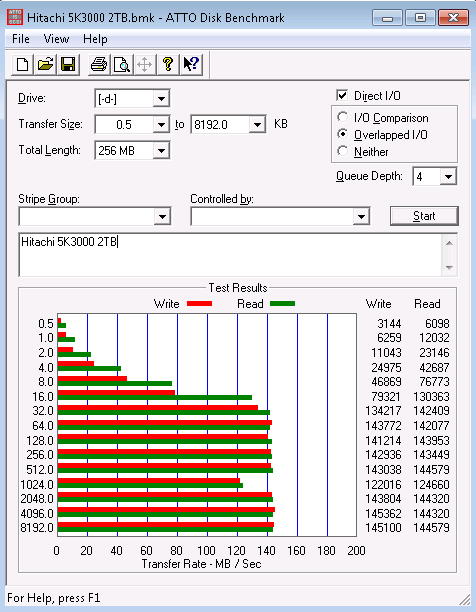

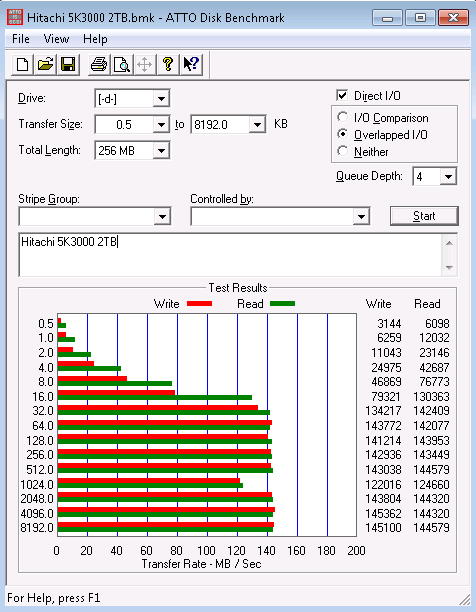

Hier ein Bechmarkergebniss einer Einzelplatte an einem Windows PC.

Nun die Messung aus einer VM die auf dem NFS Share von Nexenta liegt. Die Daten gehen also über den virtuellen VMWare Switch und werden nicht durch den echten Switch/Netzwerkkarte limitiert.

Eine annehmbare Leserate wobei ich irgendwie auf 3 x 140 = ~ 400 MB/s gehofft hatte da ich annehme das die Daten ja dreimal redundant auf allen drei HDDs liegen also parallel unterschiedliche Stücke von den drei HDDs gelesen werden können. Aber egal reicht auch so.

Aber die Schreibrate wird nicht durch das Netzwerk limitiert. Sie ist bei gruseligen max. 40 MB/s.

91 MB/s beim schreiben und 246 MB/s beim lesen sind ok. Bei einer zweiten Messung habe ich das vRam auf 4 GB erhöht. Die Schreibrate steigt dann auf 127 MB/s, sie Leserate sinkt aber auf 207 MB/s...?

Die Werte vom Bonni Benchmark sehen mit 107 MB/s schreibend und 246 MB Lesend auch ok aus.

Erste Messung von einem echten CLient über den GB Switch ohne Kompression.

Read max 25 MB/s und Lesen max. 88 MB/s.... Also im Vergleich zum 2 x 500 GB Mirror auch nicht viel Besser. Dafür das jede einzelne der neuen Platten140 MB/s schafft frage ich mich wo da die Performance verbrannt wird???

Hier ein Bechmarkergebniss einer Einzelplatte an einem Windows PC.

Nun die Messung aus einer VM die auf dem NFS Share von Nexenta liegt. Die Daten gehen also über den virtuellen VMWare Switch und werden nicht durch den echten Switch/Netzwerkkarte limitiert.

Eine annehmbare Leserate wobei ich irgendwie auf 3 x 140 = ~ 400 MB/s gehofft hatte da ich annehme das die Daten ja dreimal redundant auf allen drei HDDs liegen also parallel unterschiedliche Stücke von den drei HDDs gelesen werden können. Aber egal reicht auch so.

Aber die Schreibrate wird nicht durch das Netzwerk limitiert. Sie ist bei gruseligen max. 40 MB/s.

Hallo,

hier nochmal ein paar Tuningtipps: http://de.w3support.net/index.php?db=sf&id=92679.

Die Abschaltung des ZIL würde ich auf keinen Fall dauerhaft vornehmn, sondern nur zu Testzwecken.

hier nochmal ein paar Tuningtipps: http://de.w3support.net/index.php?db=sf&id=92679.

Die Abschaltung des ZIL würde ich auf keinen Fall dauerhaft vornehmn, sondern nur zu Testzwecken.

Nun habe ich die drei HDDs als Z1 eingerichtet so wie sie auch funktionieren sollen. Die Ergebnisse von DD Bench und Bonnie sind mit über 200 MB/s lesend sowie schreibend recht gut.

Da scheint es also kein Problem zu geben. Das Problem ist aber immer noch die Geschwindigkeit beim Zugriff über SMB.

Ergebnis von einem echten Client über den GB Switch:

Ergebnis von einer VM die auf dem NFS Share liegt (also über den virtuellen Switch geht)

Es bleibt die Frage was die Schreibrate über SMB so ausbremst. Ist das denn nur bei mir so?

Da scheint es also kein Problem zu geben. Das Problem ist aber immer noch die Geschwindigkeit beim Zugriff über SMB.

Ergebnis von einem echten Client über den GB Switch:

Ergebnis von einer VM die auf dem NFS Share liegt (also über den virtuellen Switch geht)

Es bleibt die Frage was die Schreibrate über SMB so ausbremst. Ist das denn nur bei mir so?

Vielleicht hilft dir dieser Artikel beim Samba-Tuning: http://lug.krems.cc/docu/samba/appb_02.html

Im Moment würde es mir am meisten helfen wenn mir jemand sagt wie ich die VMWare tools in der nexentaCore Installation installieren kann. Ohne GUI ist Linux doch etwas schwierig für mich.

Die Anleiteitung unteR: http://solori.wordpress.com/2010/06/17/ ... tastor-vs/

passt irgendwie nicht. Jedenfalls verzweifel ich an der Zeile: "untar VMware Tools with

tar zxvf /media/VMware\ Tools/vmware-solaris-tools.tar.gz

weil sich der Backslash "\" nicht mit altGR-ß erzeugen läßt. Auch sind die VMWare tools ja unter /cdrom/vmwaretools gemountet so das ich eh zweifel ob das passt.

Die Anleiteitung unteR: http://solori.wordpress.com/2010/06/17/ ... tastor-vs/

passt irgendwie nicht. Jedenfalls verzweifel ich an der Zeile: "untar VMware Tools with

tar zxvf /media/VMware\ Tools/vmware-solaris-tools.tar.gz

weil sich der Backslash "\" nicht mit altGR-ß erzeugen läßt. Auch sind die VMWare tools ja unter /cdrom/vmwaretools gemountet so das ich eh zweifel ob das passt.

Zurück zu „Allgemeines, Feedback & Smalltalk“

Wer ist online?

Mitglieder in diesem Forum: 0 Mitglieder und 5 Gäste